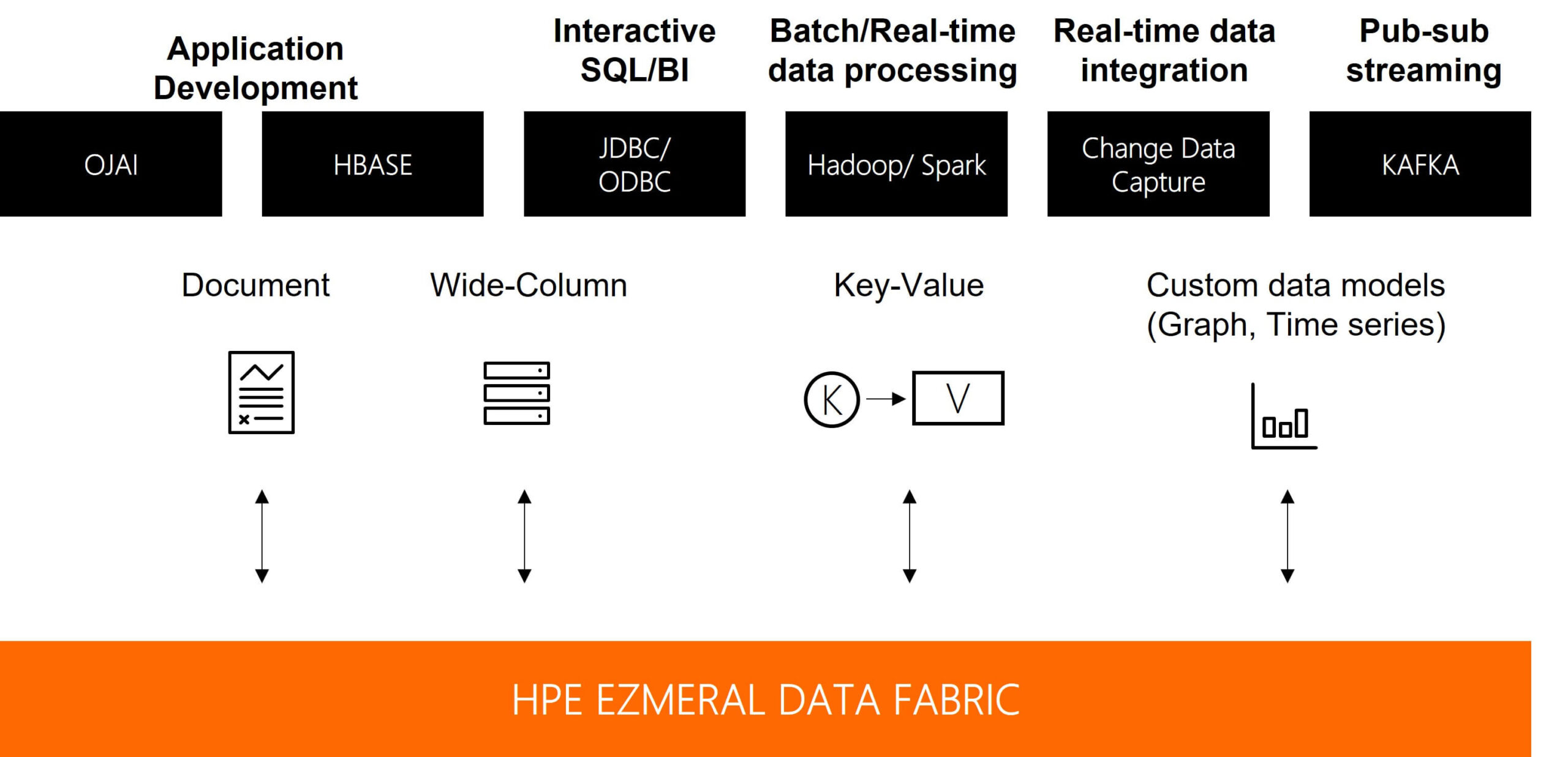

Podstawowym zastosowaniem platformy HPE Ezmeral Data Fabric jest wsparcie krytycznych biznesowo procesów związanych z przetwarzaniem danych takich jak: analityka, konteneryzacja, sztuczna inteligencja, IoT czy migracja do chmur. Tak szerokie spektrum zastosowań możliwe jest dzięki wyeliminowaniu silosów technologicznych (typowych dla danych różnego typu, pochodzących z różnych źródeł) i zapewnieniu jednej, globalnej przestrzeni nazw dla wszystkich zasobów. Co równie istotne, HPE EDF wspiera dane ustrukturyzowane oraz nieustrukturyzowane – w plikach, obiektach, tabelach, strumieniach, w tym także dane przemysłowe – z urządzeń IoT i różnego rodzaju czujników. Dostęp do nich zapewniony jest poprzez szeroką gamę powszechnie stosowanych API i protokołów (POSIX, HDFS, S3, JSON, HBase, Kafka, REST, NFS, SQL, CSI).

W połączeniu z architekturą rozproszonego geograficznie klastra oraz możliwością pozyskiwania i składowania danych w formule „edge to cloud” Data Fabric zapewnia wyjątkową elastyczność w zakresie miejsca fizycznego składowania danych – od urządzeń IoT, poprzez instalacje on-premises w lokalnych serwerowniach, skończywszy na chmurach publicznych. W każdym momencie możliwa jest również rozbudowa klastra poprzez dodanie nowych węzłów (scale-out), a samo oprogramowanie jest skalowalne dla zbioru danych o wielkości eksabajtów i bilionów plików. Optymalizację wydajności zapewnia automatyczny multi-tiering, pozwalający zarządzać „temperaturą” danych i utrzymywać najczęściej wykorzystywane dane na najwydajniejszym medium.

Artur Pająk, Lider Zespołu Projektów Technologii SAP, All for One Poland

Wysoko dostępny serwer dla SAP

HPE Ezmeral Data Fabric jako jedno z nielicznych rozwiązań technologicznych dostępnych na rynku może zostać wykorzystany w roli wysoko dostępnego serwera NFS stosowanego w rozwiązaniach SAP.

W architekturze 5-węzłowej klaster EDF pozwala na replikację danych w czasie rzeczywistym pomiędzy wskazanymi węzłami oraz określenie priorytetowego hosta, przez który jest dostępny dany zasób NFS, a także wskazanie kolejności przełączania usługi na pozostałe dostępne nody w razie awarii węzła podstawowego.

Współużytkowany podsystem pamięci masowej oparty na technologii NFS powszechnie jest wykorzystywany w najbardziej krytycznych wdrożeniach aplikacji SAP, gdy węzły klastra są rozstawione w dwóch oddalonych data centers, uzyskując ciągłość działania usługi NFS niezależnie od ewentualnych awarii serwera, macierzy dyskowej, systemu operacyjnego, infrastruktury sieciowej lub nawet całej serwerowni. Znaczenie niezawodnego rozwiązania NFS rośnie, gdy jest planowane wdrożenie usług centralnych na węzłach z innymi lokalnymi instancjami pozostającymi poza kontrolą oprogramowania przełączającego. Tego typu konfiguracja pozwala w bardziej efektywny sposób wykorzystać dostępne zasoby w przypadku uruchamiania instancji ERS czy dodatkowych instancji serwera aplikacyjnego JAVA.

Nie mniej istotnym jest sposób implementacji NFS w przypadku rozwiązania scale-out dla platformy SAP HANA. W takiej konfiguracji klaster EDF jest w stanie zapewnić dynamiczne punkty montowania dla wszystkich węzłów HANA, jednocześnie udostępniając mechanizm odporny na uszkodzenia oraz zapewniający możliwość przełączenia awaryjnego.

Producent oprogramowania SAP dopuszcza zastosowanie podczas wdrożeń tylko komponentów spełniających najwyższe kryteria ciągłości działania, niezawodności oraz dostępności infrastruktury. Rozwiązanie Ezmeral Data Fabric jest doskonałą odpowiedzią firmy HPE w obszarze współużytkowanych podsystemów pamięci masowej spełniającą oczekiwania SAP.

Artur Pająk, Lider Zespołu Projektów Technologii SAP, All for One Poland

Typowo HPE Ezmeral Data Fabric jest integrowany z narzędziami takimi jak Hadoop, Spark, Drill, TensorFlow, Kafka, Kubernetes oraz innymi z szeroko rozumianej kategorii AI/ML. Niemniej EDF sprawdzi się także w roli klastra NFS czy źródła danych dla ElasticSearcha, wykorzystywanego m.in. jako silnik analizy logów w systemach klasy SIEM.

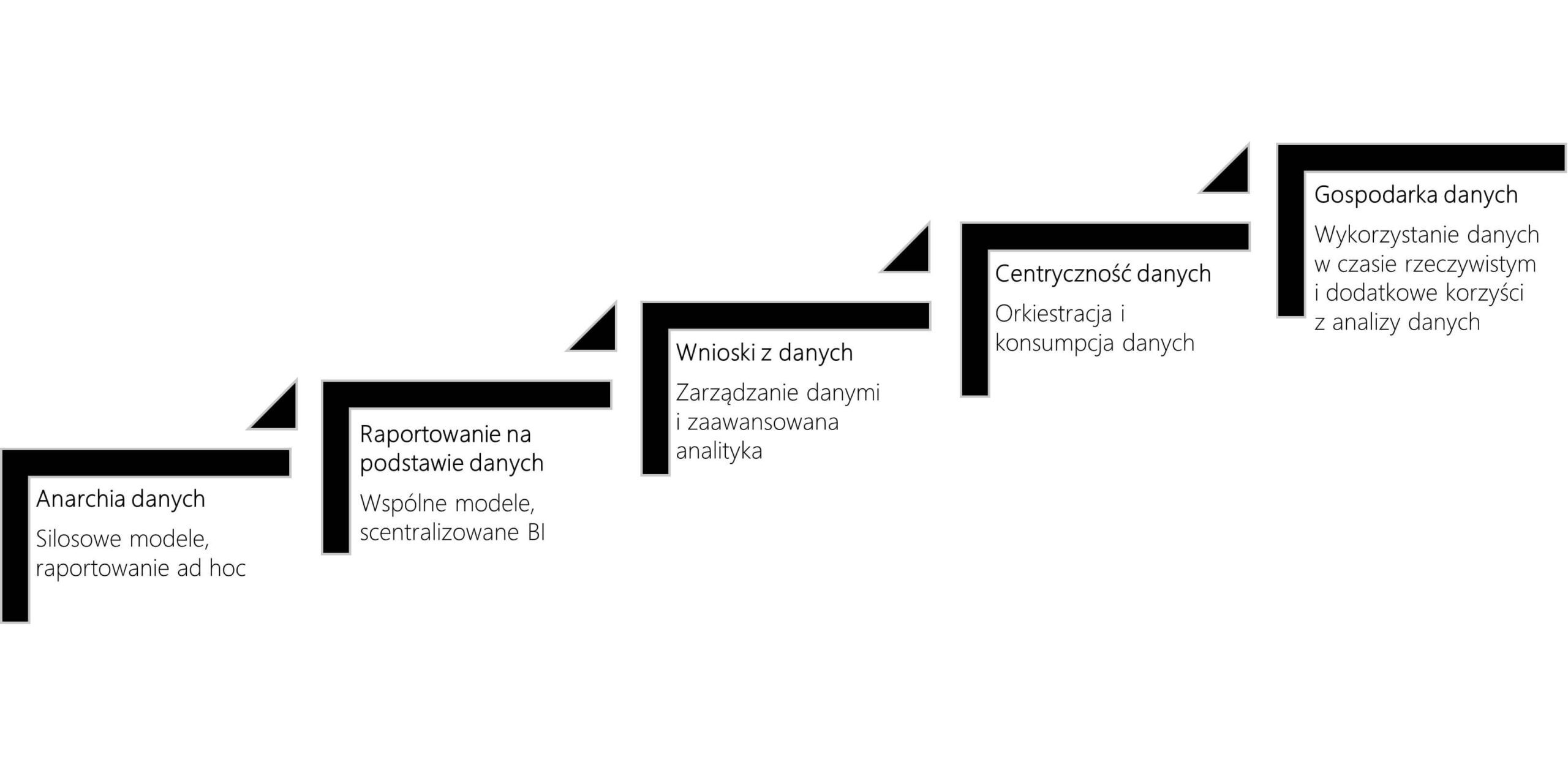

Poziomy dojrzałości organizacji w uzyskiwaniu wartości z danych (wg HPE)

Instalacja węzła HPE EDF wymaga serwera z systemem Linux (wspieranych jest kilka najpopularniejszych dystrybucji). Natomiast cały klaster Ezmeral Data Fabric powinien być złożony z co najmniej pięciu takich serwerów. W trakcie konfiguracji klastra należy rozmieścić na poszczególnych węzłach komponenty klastra, zapewniając odpowiedni poziom niezawodności poprzez umieszczenie ich na min. 2-3 nodach. W kolejnym kroku instalacji analogiczną konfigurację niezawodności należy zdefiniować dla danych, określając liczbę węzłów, na które będą one replikowane.

Podstawowe komponenty HPE Ezmeral Data Fabric

Warto podkreślić, że oprócz rozbudowanych możliwości o charakterze niezawodnościowym o bezpieczeństwie HPE EDF decyduje także szeroka funkcjonalność w zakresie uwierzytelnienia oraz wbudowane szyfrowanie danych zarówno tych przechowywanych na poszczególnych węzłach (Data-at-Rest Encryption), jak i przesyłanych przez sieć (On-Wire Encryption). Dopełnieniem aspektów bezpieczeństwa jest wbudowana opcja audytu, zapewniająca rozliczalność zarówno działań użytkowników, jak i administratorów.

HPE Ezmeral Data Fabric pozwala osiągnąć najwyższy poziom dojrzałości organizacji w zarządzaniu danymi. Dane już posiadane przez organizację mogą być dostępne łatwiej, szybciej i bezpieczniej dzięki scentralizowaniu ich na jednej platformie.

Maciej Kalisiak, HPE Presales Leader Poland, Enterprise Solutions Architect, Hewlett Packard Enterprise

Dane, architektura, skalowalność

Długo można by wymieniać zalety platformy HPE Ezmeral Data Fabric, ale kluczowych jest kilka aspektów. Pierwszym jest bardzo szerokie zastosowanie tego rozwiązania dla różnych typów danych i obciążeń, zaczynając od prostych, ale wydajnych i bezpiecznych zasobów NAS, poprzez konteneryzację, aż do zaawansowanej analityki i sztucznej inteligencji. HPE Ezmeral Data Fabric jest z jednej strony niezwykle uniwersalny, z drugiej świetnie dopasowuje się nawet do najbardziej specyficznych obciążeń.

Drugim ważnym aspektem jest rozproszona architektura, dzięki której otrzymujemy możliwość przechowywania i zarządzania danymi niezależnie od miejsca przetwarzania – od brzegu sieci, przez centrum danych klienta, aż po chmurę publiczną. To daje ogromną elastyczność, tak ważną w czasach, gdy duża część danych generowana jest na brzegu sieci, a świat IT jest prawdziwie hybrydowy.

Trzeci aspekt to ogromna skalowalność. Wydaje się to oczywiste w obecnych czasach ogromniej eksplozji danych, ale bardzo często rozwiązania mimo możliwości przechowywania dużej ilości danych nie radzą sobie z ich zarządzaniem, wydajnością dostępu czy analizą. HPE Ezmeral Data Fabric został stworzony właśnie do tego typu zastosowań, dzięki czemu praktycznie nie ma ograniczeń co do skalowalności.

Przykład zastosowania HPE EDF w roli wysoko dostępnego klastra NFS dla klastrów SAP pokazuje, że ciągle nie wyczerpaliśmy możliwości tego rozwiązania. Jeszcze pewnie nie raz EDF doskonale wpisze się w biznesowe potrzeby klientów, o których być może jeszcze nie wiemy.

Maciej Kalisiak, HPE Presales Leader Poland, Enterprise Solutions Architect, Hewlett Packard Enterprise