Czy AI zastąpi programistów?

Rozmowa między Entuzjastą, Managerem i Sceptykiem

Na podstawie ostatnich nagłówków w mediach powinienem raczej zatytułować ten tekst: kiedy AI zastąpi programistów? Jednak jeśli wczytamy się w komentarze – często pisane przez samych deweloperów, spośród których wielu już wspiera swoją pracę narzędziami GenAI – obraz nie jest tak jednoznaczny. Z jednej strony mamy grono entuzjastów, po drugiej stronie sceptyków, a pomiędzy nimi są managerowie, dyrektorzy działów, prezesi firm, którzy muszą „obstawić” jakiś scenariusz dalszego rozwoju wypadków. Zaprosiłem więc do dyskusji reprezentantów tych trzech grup, aby zestawić ze sobą ich argumenty.

Na podstawie ostatnich nagłówków w mediach powinienem raczej zatytułować ten tekst: kiedy AI zastąpi programistów? Jednak jeśli wczytamy się w komentarze – często pisane przez samych deweloperów, spośród których wielu już wspiera swoją pracę narzędziami GenAI – obraz nie jest tak jednoznaczny. Z jednej strony mamy grono entuzjastów, po drugiej stronie sceptyków, a pomiędzy nimi są managerowie, dyrektorzy działów, prezesi firm, którzy muszą „obstawić” jakiś scenariusz dalszego rozwoju wypadków. Zaprosiłem więc do dyskusji reprezentantów tych trzech grup, aby zestawić ze sobą ich argumenty.

Vibe coding

Entuzjasta: Czy znacie określenie „vibe coding”? Ten termin pojawił się w lutym 2025 r. i błyskawicznie zdobył popularność. To określenie na tworzenie programów bez… programowania. Dzięki modelom GenAI możemy po prostu podać kilka instrukcji dla modelu językowego i w rezultacie otrzymać działający program. Sprawdzamy efekt i piszemy dalsze instrukcje: co trzeba dodać, zmienić czy poprawić. W ten sposób iteracyjnie docieramy do ostatecznej wersji aplikacji.

Manager: Tak, rzeczywiście. W YouTube znalazłem bardzo efektowne przykłady tej metody. Aplikacje, których przygotowanie wcześniej zabrałoby tygodnie, mogą powstać w ciągu kilku godzin czy nawet minut…

Zastanawiam się, czy to jest w praktyce kolejna generacja języków programowania? Zaczęliśmy od kodu maszynowego, gdzie programista dosłownie składał program z zer i jedynek. Dzisiaj większość czasu spędzamy, pisząc w językach tzw. trzeciej generacji (Java, C#, czy JavaScript) lub 4GL jak SQL, ABAP. W kilku liniach kodu uzyskujemy to, co następnie przełoży się na kilkaset instrukcji dla procesora.

Mamy też od dawna obietnicę języków piątej generacji (np. Prolog), które miałyby polegać na opisywaniu problemu i warunków do spełnienia, bez zastanawiania się nad algorytmem implementacji. Jednak niewiele słychać o ich realnych zastosowaniach biznesowych. Może więc właśnie obserwujemy spełnienie założeń 5GL, tyle że innymi środkami?

Entuzjasta: Myślę, że to trafna analogia. Andrej Karpathy (autor określenia vibe coding) stwierdził między innymi, że wkrótce najbardziej popularnym językiem programowania będzie… angielski.

Sceptyk: Zgadzam się, że AI skutecznie wspiera pracę programistów, a efekty działania LLM-ów (Large Language Models) są naprawdę imponujące. Jednocześnie uważam, że z ostatnich postępów w tej dziedzinie wyciągamy zbyt daleko idące wnioski.

M: Ale to nie są tylko moje wnioski. Prezes Nvidii Jensen Huang w 2024 radził, żeby już nie uczyć się języków programowania. A Mark Zuckerberg w wywiadzie z początku 2025 stwierdził, że do końca tego roku AI zastąpi nie tylko juniorów, ale nawet średnio doświadczonych deweloperów.

S: Wspomniane filmy na YT – np. z konferencji OpenAI i Google – prezentują wąskie, sprawdzone scenariusze, które są „skazane na sukces”. Nowa interpretacja gry Snake lub Tetris, lista „to do” czy inny prosty formularz zapisujący rekordy w bazie danych. Faktycznie, w tym przypadku w kilka minut z dobrze napisanego prompta możemy uzyskać działający program. Ale w zdecydowanej większości to nie będą aplikacje gotowe do poważnych zastosowań. Kompetentny programista powinien zawsze sprawdzić ich kod – pod kątem bezpieczeństwa i prawidłowej logiki przetwarzania danych. W przeciwnym razie ryzykujemy poważne kłopoty. Część funkcji może okazać się tylko atrapami – ładnym interfejsem użytkownika, pod którym nie ma prawidłowego przetwarzania danych. Mogą też gromadzić dane użytkowników w sposób niezapewniający ich poufności.

Po drugie, kiedy aplikacja staje się nieco bardziej skomplikowana – dodajemy do niej kolejne funkcje i komponenty – szybko zmniejsza się skuteczność takiego podejścia. Coraz częściej będziemy napotykać „halucynacje”, np. próby wywołania nieistniejących serwisów i bibliotek. Ogólna architektura rozwiązania też pozostawi wiele do życzenia, jeśli nie nadzoruje jej deweloper. Vibe coding może działać, ale pod warunkiem, że znamy dany język programowania, dobre praktyki budowania aplikacji i od czasu do czasu interweniujemy, kierując pracę na właściwe tory.

E: No więc zgadzasz się, że GenAI jest pomocne i przyspiesza tworzenie oprogramowania?

S: Oczywiście. Natomiast hiperoptymistyczny ton wokół zastosowań LLM-ów to dla mnie wielka przesada. Obiecujemy przyszłość „programowania bez programistów”, która według mnie nie jest realistyczna. To tak jakbyś zapewniał kogoś, że taksówka zabierze go pod wybrany adres (i w związku z tym nie musi znać miasta ani mieć prawa jazdy), jednak w połowie drogi kierowca zaczął się gubić i pytać o wskazówki, a pod koniec stwierdził, że jednak bezpieczniej będzie, jeśli pasażer sam pokieruje pojazdem.

Czy znacie określenie „vibe coding”? To określenie na tworzenie programów bez… programowania. Dzięki modelom GenAI możemy po prostu podać kilka instrukcji dla modelu językowego i w rezultacie otrzymać działający program.

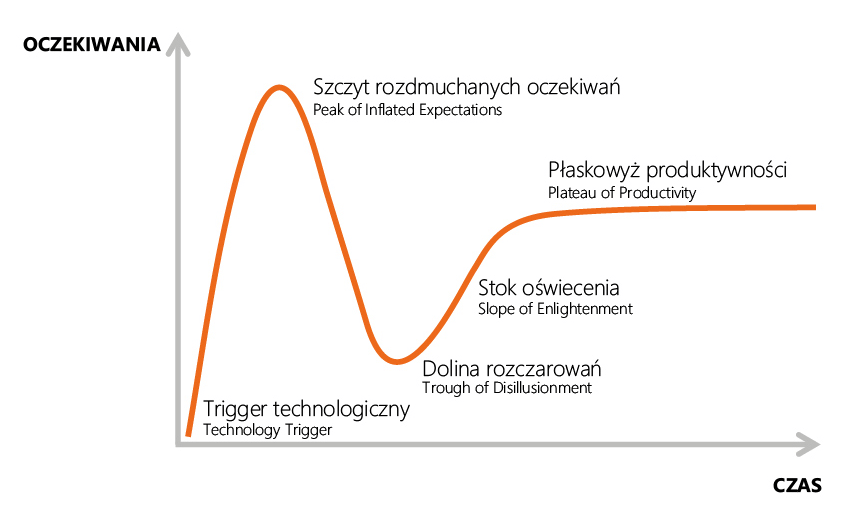

Nowe technologie na krzywej rozgłosu

M: Firma analityczna Gartner używa pojęcia „hype cycle” („krzywa rozgłosu”), żeby opisać przebieg dyskusji o nowych technologiach. Kiedy pojawia się istotna innowacja i zostaje podchwycona przez media, to oczekiwania na początku gwałtownie rosną. Szybko docierają do pułapu, który jest zdecydowanie powyżej realnych korzyści, jakie możemy uzyskać. Osiągamy więc szczyt oczekiwań, które następnie szybko spadają – bo początkowe obietnice nie zostały spełnione. Docieramy do etapu rozczarowania.

Jednak praktyczna przydatność danej technologii cały czas, konsekwentnie – ale już bez wielkiego rozgłosu – stale się zwiększa. Spadają koszty, poprawia się wydajność, mamy coraz więcej doświadczonych specjalistów. Aż w końcu krzywa oczekiwań rynku i krzywa realnych możliwości zaczynają się pokrywać. To etap zrozumienia i produktywności.

S: Tak. Najbardziej znanym przykładem tej krzywej jest tzw. bańka internetowa (dot-com bubble) w latach 1995-2002. Również blockchain, metaverse, IoT i wiele innych koncepcji podążają tą trajektorią. Moim zdaniem w odniesieniu do GenAI jesteśmy już nieco poza szczytem oczekiwań i na początku stromego zjazdu w dół. Klienci zaczynają się niecierpliwić, że wielkiego „szumu” wokół AI dostawcy nie potrafią przełożyć na realne korzyści biznesowe.

E: Sami przed chwilą potwierdziliście, że w każdej technologii z czasem spadają koszty i rośnie wydajność. Więc nawet jeśli modele językowe dzisiaj mogą zastąpić dewelopera w – powiedzmy 20% – to ich udział będzie się zwiększać, aż do 100% przewidzianych przez Zuckerberga.

S: Przyznaję, że pomimo mojego dość długiego doświadczenia w branży, wykres hype cycle nie przestaje mnie zadziwiać. Zwykle media są wyczulone na negatywne wiadomości, lubią pisać o ryzyku, bo to wzbudza większe zainteresowanie odbiorców. Tymczasem kiedy jesteśmy w pierwszym stadium, na fali gwałtownie rosnących oczekiwań – to mam wrażenie, że wszyscy wkładają różowe okulary i ignorują oczywiste ograniczenia!

Przykład pierwszy z brzegu: modele językowe trenujemy poprzez dostarczanie im ogromnych ilości danych tekstowych. Wikipedia, treść książek, repozytoria kodu, fora dyskusyjne, media społecznościowe – to wszystko materiały szkoleniowe dla LLM-ów. Dochodzimy do momentu, kiedy dalsza poprawa jakości działania będzie wymagała coraz więcej takich danych. A GenAI – mówiąc obrazowo – „przeczytała już cały internet”. Nowe treści, które oczywiście nieustannie powstają, w coraz większym stopniu będą współtworzone przez AI, więc będą mniej oryginalne, mniej „kaloryczne” z punktu widzenia poprawy możliwości modeli językowych.

Krzywa rozgłosu wg Gartnera

Sztuczna inteligencjo, ucz się sama

M: Tak wydawało się też przez dekady pracy nad algorytmami do gry w szachy lub go. Dopóki uczyliśmy te modele tylko na podstawie zasad gry i partii rozegranych przez ludzi, postęp był… niezbyt imponujący. Aż wpadliśmy na koncepcję self play. Sieci neuronowe nadal poruszały się w ramach ograniczeń wynikających z reguł gry, ale mogły iteracyjnie poprawiać swoje parametry na podstawie partii rozgrywanych między sobą. To doprowadziło do pokonania Garriego Kasparowa przez Deep Blue (1996) i Lee Sedola przez AlphaGo (2016). Dzisiaj program szachowy na smartfonie potrafi grać lepiej niż arcymistrz i to nie jest mała różnica, można powiedzieć, że to zupełnie inna liga.

E: To fakt, że dzisiaj [połowa roku 2025] nie mamy jeszcze uniwersalnego modelu uczenia metodą self play dla LLM-ów. Ale trwają nad tym intensywne badania i mamy pierwsze obiecujące rezultaty. Między innymi właśnie w zakresie automatycznego tworzenia zadań programistycznych, generowania ich rozwiązań i oceny efektów.

S: Największe sieci neuronowe, które faktycznie biją na głowę ludzi w grach logicznych (szachy, go), mają po 100 milionów parametrów. Tymczasem obecne duże modele językowe zawierają setki lub tysiące miliardów parametrów.

Kolejne tokeny wyjściowe są generowane w powolnej pętli, gdzie poprzednia odpowiedź jest używana ponownie jako dane wejściowe i cała sieć neuronowa (lub jej duża część) jest aktywowana, żeby dołożyć następny mały element. Inaczej mówiąc: wykonujemy w tych pętlach miliardy operacji mnożenia i dodawania. Nie wiem, czy kiedykolwiek ludzkość stworzyła bardziej nieefektywny sposób przetwarzania informacji!? I z jednej strony – jak już przyznałem – GenAI potrafi produkować bardzo imponujące rezultaty. Z drugiej strony od czasu do czasu zwraca fałszywe, żenująco nielogiczne odpowiedzi. Nie jestem przekonany, czy taką drogą dotrzemy do etapu, kiedy każdej odpowiedzi z LLM-a nie będzie trzeba już starannie weryfikować… Kiedy będziemy mogli im po prostu zaufać? Na razie regularnie sami możemy doświadczyć zabawnych wpadek w naszych konwersacjach z ChatGPT lub przeczytać o nich w mediach. Tylko kiedy te „wpadki” dotyczą na przykład bezpieczeństwa aplikacji, to przestają być zabawne.

E: Powtórzę wcześniej wspomniany argument – modele z czasem stają się coraz lepsze. To jest naturalna ścieżka rozwoju każdej technologii.

S: Na razie widzę raczej, że są coraz droższe w fazie szkolenia i podczas bieżącego działania. Na przykład tak zwane reasoning models, które prowadzą wewnętrzny monolog – żeby rozłożyć problem na mniejsze części, co faktycznie poprawia rezultaty – generują znacznie więcej tokenów (około 10x), niż poprzednia generacja.

W 2024 r. OpenAI – czyli najważniejszy gracz w tej kategorii – miał około 4 miliardów USD przychodu i… 9 miliardów kosztów. Sam Altman niedawno podał, że spodziewa się osiągnięcia przez firmę rentowności dopiero w roku 2029 i to pod warunkiem, że do tego czasu przychody osiągną pułap 125 mld USD. To bardzo odległa perspektywa i mam duże wątpliwości, czy to się faktycznie spełni…

LLM może być dla programisty efektywnym doradcą, dobrą alternatywą dla wyszukiwania rozwiązań w internecie. Ostatecznie dotrzemy do tej samej wiedzy, tylko szybciej.

Chatbot członkiem zespołu

M: Powróćmy do dzisiejszych realiów pracy i narzędzi, którymi już teraz dysponujemy. Czy zgadzamy się, że AI jest przydatnym narzędziem dla programistów?

S: Oczywiście. Jednak żeby z niego korzystać, musimy wypracować odpowiednie podejście. Uważam, że dobre efekty przyniesie myślenie o chatbocie nie jako narzędziu, tylko raczej kolejnym członku zespołu, który jest bardzo dobry w pewnych rodzajach zadań, gorszy w innych, a efekty jego pracy trzeba zweryfikować, zanim włączymy je do produkcyjnej aplikacji. To niewiele różni się od sytuacji, kiedy mamy w zespole analityka, architekta, starszego dewelopera i kilku juniorów, którym zlecamy dobrze zdefiniowane zadania.

M: Jakie to mogą być zadania?

S: Wspomnieliśmy na początku o tworzeniu prototypów nowych aplikacji. Wygenerowanie takiego rusztowania może zaoszczędzić wiele dni pracy, nawet jeśli później będziemy program rozwijać bardziej tradycyjnymi metodami.

Natomiast kiedy mamy już działającą aplikację, ale dawno nie zaglądaliśmy do jej kodu, możemy poprosić LLM o analizę i opisanie programu. Dzięki temu szybciej zrozumiemy jego ogólną strukturę, szybciej ustalimy, w którym miejscu należy dodać nową funkcję lub wprowadzić poprawki.

E: Od wielu lat mamy w edytorach programistycznych funkcję autocomplete, która podpowiada nazwy zmiennych czy funkcji po wpisaniu ich pierwszych liter. Teraz GenAI przenosi to na nowy poziom: potrafi proponować trafne uzupełnienie na przykład kilku lub kilkunastu linii kodu na podstawie wcześniejszego programu i tego, co napisaliśmy w komentarzach. Programista może taką sugestię odrzucić, zaakceptować w całości lub przyjąć i nieco zmodyfikować. Większość badań potwierdza, że nawet jeśli dużą część tych propozycji odrzucamy, to ogólnie wydajność pracy rośnie.

S: LLM może być dla programisty efektywnym doradcą, dobrą alternatywą dla wyszukiwania rozwiązań w internecie, na przykład na forach dla deweloperów. Ostatecznie dotrzemy do tej samej wiedzy, tylko szybciej. Chatbot porówna wiele opisów rozwiązań, wybierze z nich to, które najbardziej odpowiada naszemu zapytaniu, i jeszcze sam je nieco zmodyfikuje, poprawi. Tutaj muszę jednak przypomnieć wcześniejsze zastrzeżenie: nie możemy takich odpowiedzi akceptować bezkrytycznie.

Zadanie dla kadry zarządzającej to stworzenie bezpiecznego środowiska do pracy z GenAI. Trzeba uważnie zapoznać się z warunkami licencji i wybrać takie narzędzie, które nie będzie przechowywać kodu naszych aplikacji oraz wykorzystywać ich do dalszego trenowania modelu.

Scenariusze na przyszłość

M: Hmm… po tym co usłyszałem, potrafię sobie wyobrazić dwa zupełnie rozbieżne scenariusze dalszego rozwoju sytuacji. I nie potrafię jeszcze ocenić, który z nich jest bardziej prawdopodobny.

Pierwszy to spełnienie wizji entuzjastów. Może nie w tak bliskiej perspektywie, jaką podał Zuckerberg, ale powiedzmy za 5-10 lat. Dużą część aplikacji „biznesowych” – repozytoria dokumentów, bazy danych, raporty i dashboardy, automatyzację powtarzalnych procesów – będziemy tworzyć automatycznie z pomocą GenAI, więc popyt na pracę deweloperów istotnie się zmniejszy.

Drugi to kontynuacja dotychczasowej historii rozwoju IT. Od połowy XX wieku do dzisiaj wzrost wydajności pracy programistów był gigantyczny. Zaczęliśmy od programowania poprzez dosłownie „wbijanie” zer i jedynek na dziurkowanych kartach. Dzisiaj mamy potężne (i często darmowe) zintegrowane środowiska programistyczne, które łączą edytor kodu, debugger, analizę wydajności, proponują automatyczny refaktoring aplikacji itd. A jednak zapotrzebowanie na pracę programistów nie spadło (pomijając krótkookresowe fluktuacje), tylko stale się zwiększa. Im bardziej hardware i software stają się dostępne, tym bardziej zwiększamy liczbę ich zastosowań i w efekcie rośnie popyt na umiejętności programistów.

Managerowie muszą w jakiś sposób poradzić sobie z tą niepewnością. Dlatego proszę was na koniec o kilka praktycznych wskazówek: jakie działania podejmować, żeby dzisiaj skutecznie wdrażać GenAI do wsparcia zespołów programistów?

S: Zadanie dla kadry zarządzającej to stworzenie bezpiecznego środowiska do pracy z GenAI. Trzeba uważnie zapoznać się z warunkami licencji i wybrać takie narzędzie, które nie będzie przechowywać kodu naszych aplikacji oraz wykorzystywać ich do dalszego trenowania modelu, tzn. do generowania odpowiedzi dla innych użytkowników w przyszłości. W ten sposób moglibyśmy pozbawić się praw własności intelektualnej do własnego produktu lub naruszyć umowy o poufności z klientami, jeśli tworzymy aplikacje na ich zlecenie.

E: Zgadzam się. Natomiast poza sensownymi warunkami licencji nie jest bardzo istotne, których konkretnie narzędzi AI używamy. Kolejność w rankingu najlepszych LLM-ów w benchmarkach rozwiązywania zadań programistycznych zmienia się dosłownie co kilka tygodni. Od znajomości konkretnego modelu dla programistów ważniejsze jest po prostu zdobywanie doświadczenia – nauka współpracy z chatbotem jako „kolejnym członkiem zespołu”, o czym mówiliśmy wcześniej.

Delegowanie zadań czy przegląd i ocena cudzego kodu – to nie są ulubione zadania i silne strony wielu deweloperów. A w nowej rzeczywistości to będzie stały element ich codziennej pracy. Tyle że zamiast innej osobie, teraz coraz częściej będziemy coś zlecać AI. Dlatego warto rozwijać te kompetencje.

S: Dodam jeszcze umiejętność analizy wymagań klientów, autentyczne zainteresowanie potrzebami użytkowników aplikacji, chęć zrozumienia ich perspektywy, żeby wspólne wypracować specyfikację dla nowego programu, zamiast biernie czekać, aż biznes jasno określi, czego oczekuje.

Takie umiejętności zawsze będą cenne. Właściwe zdefiniowanie problemu, który mamy do rozwiązania, to podstawa dobrego efektu końcowego. Bez względu na to, czy kod programu napisze człowiek, czy w mniejszym lub większym stopniu współtworzy go GenAI.

M: Dziękuję za wskazówki. Jak często bywa z dobrymi radami – można je sformułować w prosty sposób, co jednak nie oznacza, że są łatwe do wdrożenia w praktyce.

Delegowanie zadań czy przegląd i ocena cudzego kodu – to nie są ulubione zadania wielu deweloperów. A w nowej rzeczywistości to będzie stały element ich codziennej pracy. Tyle że zamiast innej osobie, teraz coraz częściej będziemy coś zlecać AI

Wnioski na koniec

- Bez względu na naszą opinię na temat GenAI, te narzędzia mają korzystny wpływ na wydajność pracy programistów. Jeśli ten fakt zignorujemy, konkurencja zdobędzie nad nami przewagę.

- Jesteśmy nadal w trybie nauki i rozpoznawania możliwości/ograniczeń nowych narzędzi. Ogólnie ważniejszy jest mindset organizacji i poszczególnych programistów, niż użycie konkretnego produktu od konkretnego dostawcy; kolejność na podium najlepszych narzędzi wspierających deweloperów na razie nie jest jeszcze sztywno ustalona

- Warto inwestować w miękkie umiejętności deweloperów: umiejętności komunikacyjne, analizę wymagań, podział zadań na mniejsze części i delegowanie. Wprawdzie sama GenAI działa jako programy wykonywane przez komputery (zwykle w chmurze, czasem na naszym lokalnym urządzeniu), ale w praktyce ma wiele cech, które dotąd przypisywaliśmy ludziom, a nie algorytmom – może się po prostu mylić i konfabulować. Jednak potrafi sprawnie się komunikować i rozwiązywać takie zadania, które kilka lat temu wydawały się wyłączną domeną ludzi.

W role Managera, Entuzjasty oraz Sceptyka wcielił się

Michał Kunze, Prezes Zarządu All for One Poland